Strukturen und Verbindungen in einem Framework

Walter Kriha

Copyright © 1997 Walter Kriha

19.April 1997

Table of Contents

- 1. MANAGEMENT SUMMARY

- 2. WIESO EIN FRAMEWORK?

- 3. DEFINITION DER STRUKTUREN EINES FRAMEWORKS

- 4. DIE LOGISCHE STRUKTUR DES NEWSYS FRAMEWORKS

- 5. DIE PHYSISCHE STRUKTUR DES NEWSYS FRAMEWORKS

- 6. DIE ERWEITERUNGSSTRUKTUR DES NEWSYS FRAMEWORKS

- 7. DIE SOURCE STRUKTUR DES NEWSYS FRAMEWORKS

- 8. DIE GENERIERUNGSSTRUKTUR DES NEWSYS FRAMEWORKS

- 9. FREMDPRODUKTE IM FRAMEWORK

- 10. FRAMEWORK STRUCTURES UND CODING STANDARDS

- Welche Rolle spielt ein Coding Standard in Bezug auf die Strukturen eines Frameworks?

- WIESO CODING STANDARDS?

- Coding Standard und Tools

- Tools und Konventionen gegen Memory Leaks und Pointer Fehler

- Coding Standards und Dokumentation

- Namen für Klassen, Variablen und Packages, Components

- Programmierregeln

- Manuelle Dokumentation und Metadokumentation

- 11. VISUALISIERUNG MULTI-DIMENSIONALER DECOMPOSITION UND COORDINATION

- 12. LITERATUR

Eine Bitte an die Leser dieses Buches:

Das Buch beruht auf praktischen Erfahrungen aus einem grösseren Framework Projekt und ist daher zwangsläufig einseitig. Es hat momentan den Status eines „first draft" und enthält mit Sicherheit etliche Teile die entweder falsch, unvollständig oder unverständlich sind.

Ich bitte daher alle Leser um einen Feedback in jeglicher Form. Schön wären auch Erweiterungen oder das Einbringen eigener Erfahrung.

Die Visualisierung komplexer Strukturen und Zusammenhänge bereitete mir bereits während der praktischen Implementation die grössten Probleme. Leider hängt gerade davon die Kommunikation im Team sowie zu Anwendern ab. Gegenwärtig versuche ich Ideen hierzu zu sammeln und wäre froh über Beiträge.

Jede Software lässt sich nach den verschiedensten Kriterien strukturieren, z.B. nach logischen Abstraktionen, physischen Ableitungsverhältnissen, Runtime-, Compile- und Linktime Abhängigkeiten, Generierung und Maintenance (Build, install) sowie nach den Erweiterungsmöglichkeiten und der Organisation des Source Codes.

Diese Strukturen stehen teilweise im Konflikt miteinander, z.B. führt eine logische Ableitungshierarchie durch die damit verbundenen physischen Kopplungen zu Wartungsproblemen und langen Generierzeiten.

Ein Grund des Scheiterns vieler Software Projekte – auch und gerade objektorientierter Applikationen – liegt in der Nichtbeachtung dieser Strukturen und ihrer Wechselwirkungen. Fatal an diesen Strukturen ist zudem, dass sie im Source Code unsichtbar bleiben und dass Strukturprobleme typischerweise erst zu einem relativ späten Zeitpunkt offenkundig werden.

Dieses Buch will Softwarestrukturen offenlegen, erklären, ihre Wechselwirkungen bestimmen und Verfahren angeben, wie sie besser visualisiert werden können.

Ein Framework eignet sich besonders gut zur Untersuchung dieser Strukturen denn Frameworks zielen genau auf den oben beschriebenen Mangel normaler Applikationen: Flexibilität und Erweiterbarkeit durch strukturelle Mechanismen. Ein Framework enthält dieselben Strukturen wie jede andere Software, macht sie aber gleichzeitig explizit, sichtbar und programmtechnisch greifbar als Voraussetzung für Erweiterbarkeit. Ein Framework enthält somit Code der sich seiner Austauschbarkeit bewusst sein muss. Frameworks sind daher essentiell reflektive, dynamische Systeme.

Der typische Ansatz die Komplexität einer Software durch Isolierung von Componenten und Packages zu reduzieren funktioniert gerade in einem Framework so einfach nicht: Innerhalb eines Frameworks SOLLEN Klassen und Componenten miteinander agieren um eine Lösung zu erreichen. Dieses Paper zeigt Wege auf, Kooperation trotz Separation zu erreichen.

Wissen um die technischen Aspekte eines Frameworks ist eine notwendige Voraussetzung für erfolgreiche Projekte. Trotzdem scheitern Projekte regelmässig trotz technischen Wissens. In der praktischen Erfahrung vermischen sich technische Strukturen und soziale Strukturen der Organisation der Arbeit zu einem komplexen Gebilde. Deshalb – nicht zuletzt aus eigener schmerzlicher Erfahrung – versucht diese Arbeit auch die soziale Strukturen der Erstellung und Verwendung eines Frameworks zu bestimmen. Dabei geht sie von drei Thesen aus:

Dass unsere technischen Denkbilder und Modelle sowohl von den sie begleitenden sozialen Strukturen bestimmt sind als auch umgekehrt neue technische Modelle neue Formen der sozialen Organisation bedingen.

Komplexe Projekte häufig an den sozialen Strukturen scheitern, die den technischen entweder nicht angemessen sind oder ihnen entgegenarbeiten.

Dass wir technische Interfaces auf minimale Berührungsflächen hin entwerfen sollten. Soziale Interfaces sich jedoch zu ihnen orthogonal oder netzartig verhalten und auf maximale Berührungspunkte hin organisiert sein sollten.

Der technische Teil der Arbeit zeigt ganz konkrete Lösungen für flexible, dynamische und adaptive Systeme mit der Betonung auf der möglichst vollständigen Betrachtung des Lebenszyklus eines Produktes und der dynamischen Abhängigkeiten zwischen seinen Teilaspekten.

Im sozialen Teil werden ebenfalls konkrete Lösungen für die Enführung neuer Technologie, die Organisation der Arbeit in komplexen Systemen und die Auswahl neuer bzw. der Umgang mit bestehenden Mitarbeitern aufgezeigt. Wenn dabei Kriterien für Kündigung und Selektion fallen dann nicht weil der Autor der Meinung ist, dass eine gewisse Brutalität für die Einführung neuer Technologie unbedingt nötig und wünschenswert ist sondern weil Kündigungen häufig der letzte Ausweg aus völlig festgefahrenen Denkbildern und falschen Organisationsformen sind. Es gilt die Ursachen dafür zu finden dass technische Modelle religiösen Charakter erhalten, die Mitarbeiter völlig unflexibel werden und wir den Produktionsprozess von Software auf eine Weise organisieren die Konfrontation und Politik statt bessere Produkte erzeugt.

Die Überlagerung technischer und sozialer Strukturen bestimmt letztlich den Erfolg eines Projektes.

Um diesen Zusammenhang deutlich zu machen trägt die Arbeit das Kunstwort „Frameworking" im Titel.

Ein Wort zu den Voraussetzungen:

Dies ist kein Buch über Design Pattern. Im Gegenteil, es setzt die Kenntnis von Design Pattern schlicht voraus. Frameworktechnologie ist ohne die technischen und kommunikativen Hilfen der Design Pattern kaum möglich.

Dies ist auch kein Buch zum C++ oder Java lernen. Wer die Standardwerke zu C++ nicht kennt, speziell die Problematiken um die physischen Abhängigkeiten und die Behandlung von Interface und Class dem werden die Schwierigkeiten dynamischer Lösungen mit C++ unverständlich bleiben..

Das gleiche gilt für Java. Kenntnis von JDK1.1, Class Loading, Reflection etc. wird vorausgesetzt.

Eine Basiskenntnis von distributed object Technologien wie CORBA oder DCOM ist ebenfalls sehr nützlich.

Nicht zuletzt soll dieses Buch als Basis für eine Serie von Systor internen Workshops zur Anwendung von Design Patterns und Frameworktechnologie dienen.

Table of Contents

Selten fängt ein Projekt mit der Zielsetzung „Wir bauen ein Framework" an. Oft steht die Erkenntnis, dass ein Framework Desing nötig gewesen wäre erst am Ende eines Projektes fest. Wenn der erste Prototyp oder die erste Auslieferung zeigen, dass man wesentliche Gesichtspunkte wie Flexibilität und Erweiterbarkeit zu wenig bedacht hat. Üblicherweise ist dann bereits eine Menge Code entwickelt worden und das Projektteam steht mit dem Rücken zur Wand, da jede Änderung oder Erweiterung einen quadratischen Aufwand bedeutet.

Wir wollen am Beispiel eines Businessprojekts die Entwicklung zum Framework nachvollziehen – das „Framework-Denken" verdeutlichen. (Das Beispiel beruht auf einem vom Autor selbst entwickelten Framework für Document Imaging und Workflow).

Das Beispiel schliesst ganz bewusst auch die sozialen und organisatorischen Strukturen einer Framework-Entwicklung ein, die nach eigener Erfahrung einen grösseren Einfluss auf den Erfolg von Projekten haben als die technischen Strukturen.

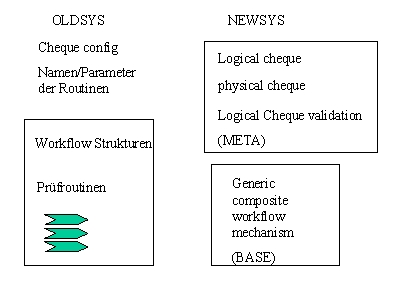

Firma X hat ein Produkt „OLDSYS", eine Kombination aus Software und Hardware für Belegverarbeitung in verschiedenen Branchen.

Aufgaben von OLDSYS:

Das Paket ist sehr erfolgreich, hat aber einige Eigenschaften, die bereits jetzt oder in absehbarer Zukunft zu enormen Problemen führen werden, nichts zuletzt auf Grund der gestiegenen Kundenzahl. Das Kontrolling der Produkte findet kaum statt. Es ist nicht transparent welche Produktfehler in welchem Umfang durch die Servicegruppe abgefangen werden. Entwicklern gelingt es immer wieder, Unzulänglichkeiten der Software auf die Servicegruppen abzuschieben. Die Servicegruppen sind hoch motiviert und haben ein ausgesprochenes „Just do it" Denken.

Eigenschaften von OLDSYS:

MS-DOS basiertes Toolkit mit branchenspezifischen Applikationen, eigenes Memory Management, eigene ISAM Datenbank, eigenes GUI unterstützt durch eigene Keyboard und Video Driver. Eigene Treiber zum Anschluss von Peripherie (Scanner)

Modulkonzept: Module zur Verarbeitung werden durch einen eigenen Lademechanismus zur Laufzeit geladen und zu bestimmten Zeitpunkten vom Kernel aufgerufen. Die Module werden durch Einträge in ein Konfigurationsfile bestimmt.

Flexibilität durch Konfigurationsfiles: Der gesamte Ablauf sowie die Logik von Belegprüfungen werden durch Konfigurationsfiles bestimmt.

OLDSYS ist in C und teilweise in Assembler programmiert. Zentrale Datenstrukturen sind in Dokumenten beschrieben und werden in allen Modulen gekannt und verwendet.

Neue Peripherie kann integriert werden, z.B. wenn neue Scanner Typen kommen. Integriert wird neue Peripherie im wesentlichen im Modell des ersten unterstützten Scanners.

OLDSYS ist sehr performant, nicht zuletzt weil es ein eigenes GUI besitzt und direkt auf DOS bzw. unter Umgehung von DOS arbeitet.

OLDSYS ist kostengünstig, da die Konkurrenz momentan noch grössere und damit teurere Systeme zum selben Zweck einsetzt.

Trotz des Erfolges sieht das Management einige technische und soziale Probleme, die zum Wunsch nach einem Redesign von OLDSYS führen.

Problem mit OLDSYS aus der Management Sicht:

OLDSYS wurde im wesentlichen von einer Person entwickelt, die das Unternehmen verlassen wird.

Kenntnisse zu den Interna sind nur schwer erhältlich obwohl der Code ursprünglich sauber und übersichtlich programmiert war. Nach einigen Erweiterungen sind die Abhängigkeiten der Funktionen und Datenstrukturen nicht mehr klar. Änderungen oder Erweiterungen verursachen obskure Fehler in anderen Modulen.

Die Kunden wollen Windows oder OS/2 bzw. Motif Unterstützung.

Die Wartung/Entwicklung der eigenen Treiber multipliziert sich pro Plattform.

Der Konfigurationsaufwand „skaliert" nicht, d.h. je mehr Kunden umso grösserer Konfigurationsaufwand da mit „copy and paste" gearbeitet wird. Neue Hardware führt zu einem überproportionalen Aufwand an Konfiguration.

Neue Mitarbeiter tun sich sehr schwer mit der Konfiguration. Es entstehen viele Fehler beim Kunden. Der Gewinn pro zusätzlichem Kunden ist abnehmend durch gestiegenen Serviceaufwand.

Änderungen dauern immer länger und führen zu obskuren Nebeneffekten. Das System selbst wird immer grösser. QA-Probleme sind vorhanden, z.B. bezüglich des Release Managements.

Es sind keine automatischen Updates möglich, da die Änderungen von Hand durchgeführt werden. Es gibt immer mehr Speziallösungen für einzelne Kunden. Die alte Zweiteilung des Systems in Toolkit und branchenspezifische Applikationen existiert kaum noch. Neue kundenspezifische Applikationen entstehen durch „cut and paste" aus vorhandenen. Dies führt dazu, dass bei Fehlerbehebungen unzählige Module geändert werden müssen. Bei Sonderwünschen muss meistens so verfahren werden, dass sie Teil der System oder Applikationsbasis werden und somit VON ALLEN KUNDEN mitgeschleppt werden müssen.

Konventionelle Software degeneriert im Laufe der Zeit. Durch notwendige Änderungen und Erweiterungen wird die ursprünglich saubere Struktur zerstört.

Alles dies veranlasst das Management über ein neues Produkt „NEWSYS" nachzudenken. Zwei grundlegende Richtungen bestehen:

Die Entwickler des alten Systems bevorzugen den Gedanken der Weiterentwicklung. Die Geschäftsleitung – beunruhigt durch die bereits deutlich längeren Releasezyklen des alten Systems – entscheidet sich für die Neuentwicklung mit Integration von Komponenten des alten System. Dazu wird ein völlig neues Team angeworben und in der Firma installiert. Die Mitglieder des neuen Teams verfügen über keine Branchen- oder Domainkenntnisse und sehr unterschiedliche OO-Kenntnisse.

In einigen anfänglichen Meetings wird versucht mit einer Gruppe von älteren und neueren Mitarbeitern ein Anforderungsprofile für NEWSYS zu entwickeln. Die Vorschläge der älterne Mitarbeiter sind sehr konkret und detailiert, beziehen sich aber im wesentlichen auf inkrementelle Verbesserungen des bestehenden Systems. Der Prozess schläft nach einigen Monaten ein und wird anschliessend fast selbständig im Team von NEWSYS durchgeführt. Bereits nach kurzer Zeit tritt eine Isolierung des NEWSYS Teams auf, die sich im Laufe der Zeit noch verstärkt, nicht zuletzt durch den Entschluss ein Framework zu bauen. Die Applikationsgruppen stehen dem Projekt zu Anfang wohlwollend gegenüber, nicht zuletzt auf Grund persönlicher und technischer Probleme mit der OLDSYS Gruppe.

Anforderungen an „NEWSYS":

Erschliessen neuer Märkte durch Ausweitung des Dokumentenmodells

Kompatibilität mit den alten Datenstrukturen, d.h. beim Kunden sollen OLDSYS und NEWSYS Versionen zusammen laufen können, z.B. die gleichen ISAM Datenbanken verwenden.

Projektdauer ca. 1 Jahr mit frühen Prototypen und inkrementellen ersten Teilversionen (Die Firma hatte pikanterweise bereits lange vor Projektbeginn Dummys des neuen Produktes auf Messen gezeigt)

Vorgaben: Entwicklung in C++ („damit der Umstieg leichter fällt", Verwendung eines GUI-Toolkits für plattformunabhängige User Interfaces.)

Das NEWSYS Team begann mit der Analyse der Domain-Aspekte (was wird im Banken und Versicherungsumfeld benötigt) sowie einer Analyse des bisherigen Systems (Wie funktioniert OLDSYS?). Die Mitglieder des NEWSYS Teams hatten nur geringe Kenntnisse der Applikationsdomain und gar keine Kenntnisse des alten Systems. Dies stellte sowohl einen Vorteil wie auch einen Nachteil dar. Der Vorteil bestand darin, dass die Vorstellungskraft der Teammitglieder nicht durch die Kenntniss der Implementation des alten Systems von vorne herein eingeschränkt war.

Wie sehr die Macht der Denkgewohnheiten gefürchtet ist zeigte sich in einem spontanen Kommentar eines C++ Spezialisten der einen für uns einen C++ Kurs hielt, nachdem wir ihm von unserem Projekt erzählt hatten: „aber doch wohl nicht mit den alten (OLDSYS) Leuten!" Damals hatte ich diese Aussage als eher arrogant und peinlich angesehen, im Nachhinein – nach viel Lehrgeld – muss ich ihm zumindest teilweise Recht geben. Von Benjamin Lee Whorf gibt es ein (angenehm kleines) Taschenbuch mit dem Titel „Sprache, Denken, Wirklichkeit". Er gibt dort Beispiel wie sehr wir über die Begrifflichkeit unserer Sprache im Denken geleitet werden. Seine Analysen z.B. der Hopi Sprache und Kultur sind m.E. methodisch sehr fragwürdig, seine Beispiele aus dem Alltagsleben hingegen sind auf Grund eigener Erlebnisse sehr eingängig und gut nachzuvollziehen. Es mag lächerlich klingen, aber es ist ein grosser Unterschied ob ich einen Scheck als „Beleg" bezeichne oder als „Dokument". Dokument lässt einen viel weiteren geistigen Spielraum zu, z.B. über die verschiedenen physischen und logischen Arten mit denen ein Scheck realisiert werden könnte. Durch diese gedanklichen Alternativen erscheint ein konkretes Scheckformular nur als Spezialfall möglicher Scheck-Dokumente. Das Allgemeine (logischer Inhalt, Struktur) trennt sich vom Speziellen (physische Repräsentation, Format) und beides tritt klarer hervor.

Der Nachteil der geringen OLDSYS-Kenntnisse bestand darin, dass die Analyse des alten Systems entsprechend mühsam war.

Ziel der Anforderungsanalyse war wie gesagt die Ausweitung des Dokumentenbegriffs von „Beleg" (Scheck, Einzahlungsformular, Wahlzettel, Zeitabrechnung etc.) hin zu „Dokument".

Bald stellte sich heraus, dass typische Begriffe aus OLDSYS für die erweiterte Sichtweise nicht benutzbar waren und deshalb durch allgemeinere Begriffe ersetzt wurden. Fortan sollten die alten Begriffe nur noch genau die Bedeutung besitzen, die sie im OLDSYS System hatten und auch nur noch dort angewandt werden. OLDSYS Mitarbeiter weigerten sich standhaft diese Begriffe zu verwenden und stellten in der Folge jede Mitarbeit ein.

Nichts spaltet eine Firma gründlicher als eine neue Sprache die aus einer neuen Sichtweise stammt.

In der Folge entstand zunächst ein Gemisch aus alten und neuen Begriffen das zu reichlich Verwirrung führte und das Ziel verfehlte, nämlich eine höhere Abstraktionsebene zu erreichen.

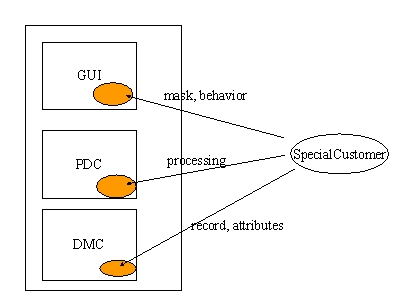

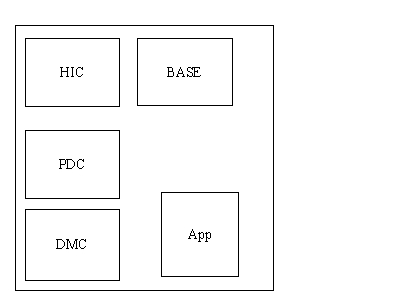

Das NEWSYS Team entschied sich frühzeitig, die OO-Methodik von Coad/Yourdon einzusetzen, „brave OO-Bürger" zu sein. Entsprechend dieser Methodik wurden Analyse und Design durchgeführt und ein Prototyp einer ersten Teilfunktionalität entwickelt. Es entstand ein logisches Domain-Modell das die Applikation in HIC (User Interface), PDC (Problem Domain) DMC (Data management) aufteilte. Basis- Funktionalität wurde in gemeinsamen Basis Klassen gesteckt.

Nicht erkannt wurde vom Team, dass speziell das Vorgehen von Coad/Yourdon sich speziell für kleinere und unabhängige Applikationen eignet, nicht jedoch für grössere Toolkits.

7 Monate nach Projektbeginn war ein erster Prototyp entstanden der zum grossen Entsetzen des NEWSYS Teams zwar objektorientiert programmiert war aber:

Auch guten OO- Bürgern widerfährt Böses.

Die Ergebnisse einer objektorientierten Analyse können nicht einfach in eine Applikation umgesetzt werden. Die Logik der Applikation kann stimmen OHNE dass die Versprechen der OO-Bewegung (Kapselung, Wartbarkeit, Erweiterbarkeit etc.) eintreffen.

Das Signal des Prototypen an die firmeninterne Umwelt war eindeutig: Fehlschlag

Bereits während der Entwicklung des Protoypen beschäftigte sich der Leiter des NEWSYS Teams (der als einziger der Gruppe aus der Systementwicklung kam) verstärkt mit Opendoc und Fresco. Speziell Fresco, ein OO–Gui Framework im Source verfügbar- enthielt Mechanismen der Flexibilität (CORBA, Design Patterns). Der CORBA Kernel von Fresco wurde auf OS/2 portiert und der dahintersteckende – noch ziemlich unklare - Begriff des Frameworks in die Gruppe eingebracht. Damit entstand gleichzeitig eine Sichtweise die mehr von einem Systemkonzept als von herkömmlicher Applikationsprogrammierung ausging.

- Die Auftrennung der Applikation in logische Domains verhinderte nicht ihre physische Verbindung. Logisch war die Applikation modular, physisch war sie ein Monolith.

Die Compile und Linkabhängigkeiten können nur durch die Trennung von Interfaces und Implementations erreicht werden.

Object Creation ist einer der grossen „cold spots" (unflexible Teile) in einem System

GUI Componenten müssen dynamisch zur Laufzeit mit Applikationslogik verbunden werden.

GUI Componenten verwenden ein Protokoll zur Kommunikation mit Model Objekten (logische Separation)

GUI Componenten dürfen NUR über ein Interface mit Objekten des Models sprechen. (physische Separation)

Konfigurationsinformation muss SICHER verwaltet werden können. Es ist ein symbolisches Type System für Meta Information nötig.

Der Abstraktionsgrad der verwendeten Objekte war noch zu gering: z.B. spiegelte die „Beleg" Klasse darunterliegende Low Level Funktionalität in ihrem Interface. Damit wären nie generische Clients denkbar.

Ein Metadaten-Modell für Objekte ist nötig. Information darf nicht kopiert werden. Statt z.B. Datenbank Schemata im Source zu codieren müssen sie aus Beschreibungen zur Laufzeit generiert werden können.

Peripherie muss ohne Recompile oder Linken dynamisch ins System integriert werden können.

Fremdprodukte dürfen nur gekapselt ins System eingeführt werden.

Dynamisches Austauschen einzelner Klassen muss möglich sein (Wartung und Erweiterung)

Neue Formen der Wissensweitergabe sind nötig, da bereits vier Personen gegenseitig die Implementationskenntnisse nicht mehr austauschen können: Design Patterns

Das System muss zur Laufzeit durch Komposition von Objekten anpassbar sein, d.h. die Verbindung von Objekten muss am Ort ihrer Verwendung geschehen und nicht statisch zur Compilezeit („closer to actual usage time", Ron Resnick, distributed objects mailing list). Neue Konzepte wie Java-Spaces, Java-Infobus und allgemein Objektbus Technologie (z.B. iBus) oder Event Modelle wie der CORBA Event Service zielen ebenfalls auf dieses Problem.

Neben den logischen Strukturen einer Applikation gibt es eine Reihe anderer Strukturen (physische, Runtime, Extension etc.) die ALLE entscheidend zum Erfolg beitragen, jedoch in der objektorientierten Modellierung NICHT AUFTAUCHEN.

Der Prototyp hatte unser mangelhaftes Verständnis der physischen Aspekte von C++ sowie die Mängel im OO-Verständnis insgesamt (Interfaces, abstract data types) gnadenlos aufgedeckt.

Danach haben wir durch intensives Studium von Literatur und PD Source Code versucht unser System zu verbessern.

Die entscheidende Literatur war, ungefähr in dieser Reihenfolge:

Stroustrup, diesmal auch die HINTEREN Seiten. (Interfaces etc.)

Scott Meyers erstes Buch ( low level aspekte von C++, multiple inheritance)

Lakos, physical Aspects of C++ (fundamental, für uns nur leider zu spät bzw. wegen bereits durchgeführter Interface/Implementation Trennung nicht mehr so relevant.

Sowie parallel dazu der C++ Report sowie das Object Spektrum und gelegentlich JOOP. Source Code Studium: Fresco

Was kann man danach?

Die schlimmsten Fehler vermeiden. (Dieser leicht zynische Kommentar resultiert aus der Erkenntnis, dass man selbst nach ausgiebigem Lernen in C++ häufig vor Alternativen steht, die alle nicht optimal sind und dass die physischen Abhängigkeiten doch einen enormen Einfluss auch auf das Design erhalten)

Die objektorientierte Modellierung an sich hatte sich nicht als falsch herausgestellt. Sie musste jedoch in 2 Aspekten deutlich abgeändert werden.

Die erst Erkenntis war, dass es nicht genügt nur die statischen Aspekte von Dingen der Wirklichkeit zu analysieren bzw. zu modellieren, d.h. die OOA wurde in erster Linie als unvollständig erkannt.

Zur Begründung:

Wenn man Analysemodelle von Business-Applikationen betrachtet fällt auf, dass sich die meisten auf den statischen Aspekt eines Objektes konzentrieren, z.B. wird ein Objekt „Beleg" mit seinen Attributen modelliert. Was nicht modelliert wird ist woher die Objekte kommen, wer sie erzeugt, welche Phasen sie durchlaufen, kurz: die Analyse beschränkt sich häufig auf die Teile, die letztlich als Records einer Datenbank enden. Ebensowenig wird berücksichtigt, dass sich wirkliche Objekte in ihrem Verhalten stark ändern können d.h. abhängig von ihrem Kontext sind ohne ihre Identität zu verlieren (d.h. Class und Identity sind unterschiedlich im Laufe der Zeit). Wirkliche Objekte können ihr Verhalten abstimmen auf den jeweiligen Sender einer Nachricht was die meisten OO-Programmiersprachen nicht ohne massive Eigenprogrammierung ermöglichen.

Resultat:

Die Möglichkeiten der momentanen OO-Sprachen und altgewohnte Sichtweisen aus der Datenwelt bestimmen unsere heutigen OO-Analyse die damit zwangsläufig stark verkürzt und unvollständig bleiben.

Die Konsequenz:

Die Objektaspekte, die in der Analyse unberücksichtigt geblieben sind, tauchen als Problem erst viel später im konkreten Design auf bzw. schlimmstenfall erst beim nötigen Redesign des Produktes weil z.B. versäumt wurde die massenhafte Integration neuer Objekte zu berücksichtigen.

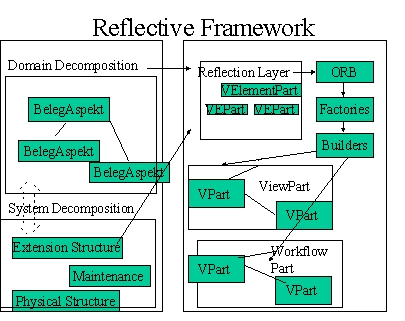

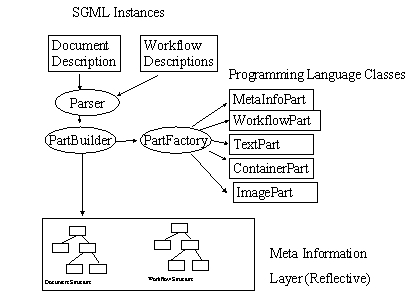

Das wahrscheinlich wichtigste Ergebnis der Problemanalyse war, dass nicht mehr von einem einfachen Abbildungsmodell der Analyseobjekte auf Design- und Implementationsobjekte ausgegangen wurde sondern über mehrere Stufen eine reflektive Architektur sowohl des Gegenstandsbereichs als auch der „Maschine" des Frameworks entstand. Diese Architektur lässt offen ob sowohl Gegenstandsbereich als auch Maschine in Form von Objekten analysiert werden und in welcher Form die Implementation (Abbildung) erfolgt.

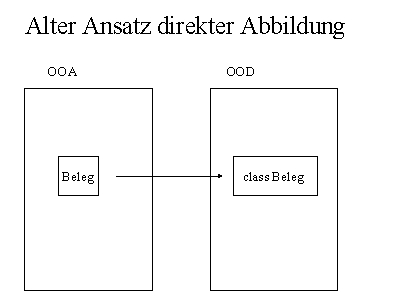

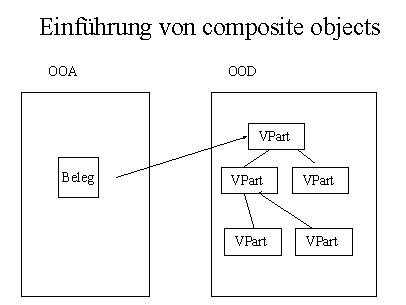

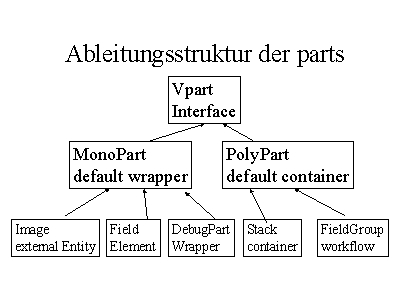

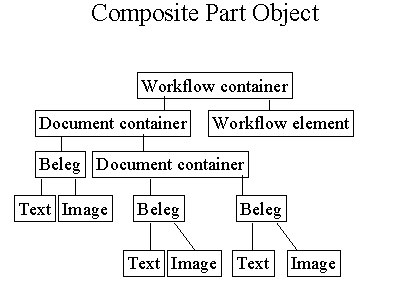

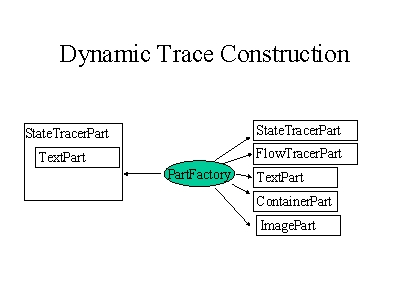

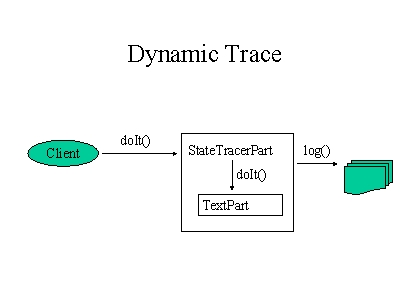

Im ersten Ansatz waren wir von der direkten Abbildung ausgegangen. Dem liegt ein erkenntnistheoretischer Kurzschluss zugrunde: Wenn wir über Tische reden funktioniert unser Denken mit Hilfe von Tisch Objekten im Gehirn. Wir haben durch unsere Sprache zweifellos ein Objektmodell der Wirklichkeit zur Verfügung. Die Art und Weise der Verarbeitung dieses Objektmodells im Gehirn (Maschine) muss jedoch keineswegs in Form von Objekten erfolgen bzw. es können Objekte gänzlich anderer Art beteiligt sein. Dies führte zu einer erstem Zwischenstufe eines erweiterbaren Frameworks durch die Einführung von composite objects. Was auf der Ebene der Analyse ein Objekt war und meist auch eine Repräsentation der Wirklichkeit intendierte, wurde im Design abgebildet auf eine Objektbaum der zur Laufzeit dynamisch zusammengebaut wurde. Mechanismen aus Fresco wurden für die Architektur der composite objects übernommen (allgemein zum composite object pattern: [GOF96])

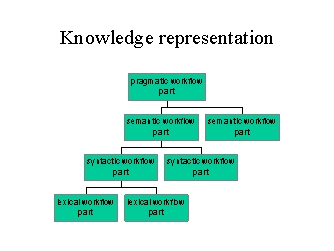

Damit wurde es möglich die verschiedensten Belegsorten aus wiederverwendbaren Teilen zusammenzubauen ohne dauernd neue Klassen definieren zu müssen. Dennoch gab es eine ganze Reihe von Funktionalitäten die auf den ersten Blick so aussahen als seien sie nur bei einigen Typen von Belegen anwendbar, z.B. Informationen und Funktionen zur physischen Ausprägung. In einem nächsten Schritt wurde versucht, ein generisches Framework durch sog. Multi-Dimensionale Decomposition der Problem Domain zu erreichen. Hierzu wurden die verschiedenen Aspekte von Belegen herausgearbeitet: logischer Aufbau, verschiedene Möglichkeiten physischer Representation, verschiedene Darstellungsmöglichkeiten (Views) und nicht zuletzt verschiedene pragmatische Bedeutungen wie z.B. das Vier-Augen-Prinzip im Bankbereich.

Jeder einzelne Aspekt wurde nun seinerseits als Dokument ausgedrückt und konnte je nach Bedarf mit anderen verknüpft werden. Die Art und Weise der Bildschirmdarstellung war jetzt z.B. nicht mehr eine Eigenschaft des Dokumentes selbst sondern in einem eigenen Dokument (Stylesheet, Viewdescription) festgehalten.

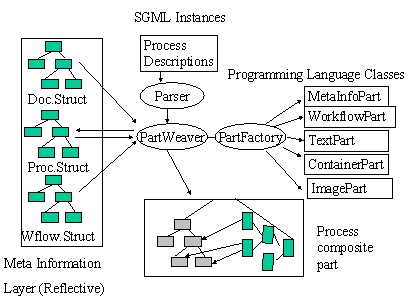

In einem letzten Schritt wurde dieses Verfahren jetzt auch auf das Framework selbst angewendet und damit der Schritt zum selbstreflektiven Framework vollzogen

Es fand eine Decomposition der Problem Domain Strukturen sowie der dem Framework eigenen Strukturen in Verbindung mit den Domain Strukturen statt. Anschliessend erfolgte mit Hilfe der Meta Information eine Coordination zur Laufzeit.

Die Metainformation enthielt das Konzept eines Belegobjektes sowie seiner Aspekte, repräsentierte also eine Abstraktion sowie konkrete Ausprägungen. Die Realisation funktionierte ganz anders und ohne direkten Bezug zu einem Objekt der OOA sondern vermittelt über die Metainformation.

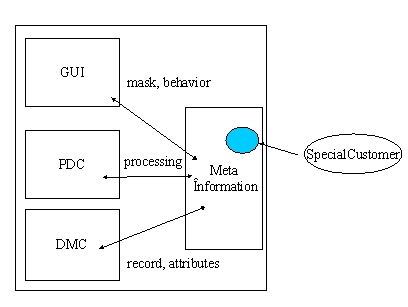

(Das Diagramm zeigt nur einen kleinen Teil der beteiligten Strukturen und Aspekte!)

Sowohl Problem Domain als auch Framework selbst wurden Teil der Analyse. Die Ergebnisse flossen konstruktiv ein in die Meta Information des Reflection-Layers. Realisiert wurde der Reflection-Layer durch dieselben Vpart Klassen (V denotiert eine Interface Klasse) die auch zur Laufzeit zur Bearbeitung konkreter Dokumente verwendet wurden, d.h. die MetaInformation wurde ebenfalls ein Dokument.

Verschiedenste Bearbeitungen konnten damit zur Laufzeit konstruiert werden.

5) Generative und generische Ansätze

Die eben geschilderte Entwicklung ist bewusst auf generische Verfahren ausgelegt. Dass dies nicht die einzige Möglichkeit ist, soll in 2 Beispielen aus der Business orientierten Software Entwicklung gezeigt werden.

Im Bereich des Business Processing (z.B. Finanzdienstleistungen) dominieren meist zwei andere Verfahren.

Das erste erstellt in einem ersten Schritt ein grobes Objektmodell der zu lösenden Aufgaben (z.B. eine Kundenbearbeitung) und beginnt dann gleich mit der Implementation in Form direkter Abbildung es Objektmodells in die Implementation. D.H. es wird so vorgegangen wie im unter 1) geschilderten Fall. Begründet wird das Vorgehen damit, dass man erstens nur für einen Kunden arbeitet, zweitens die Aufgabe sehr speziell und abgegrenzt ist und drittens der Umfang der zu entwickelnden Software überschaubar klein ist. In der Praxis lässt sich keine der Begründungen auf Dauer halten. Die Auffassung dass man nur für einen Kunden arbeitet vergisst zwei Dinge: Gleiche Dinge werden dadurch in verschiedenen Abteilungen immer wieder neu entwickelt. Die Kosten solcher Spezialsoftware treiben selbst Banken und Versicherungen in die Arme von Outsourcing Unternehmen, d.h. man sägt am eigenen Ast. Ausserdem ist die Auffassung dass man speziellen Problemen mit speziellen Lösungen am besten begegnet einfach falsch. Auf Generalisierung zu verzichten bedeutet in das berüchtigte „Inventors Paradox" zu laufen. Es stellt sich nämlich oft heraus, dass eine generelle Lösung wesentlich kleiner und leichter ist als eine sehr spezielle.

Leider stimmt auch die zweite Annahme, dass die Aufgabe genau eingegrenzt ist nicht. Ich habe noch keinen Kunden ohne Änderungs- und Erweiterungswünschen erlebt. Dies ist aber gerade dann nicht mehr möglich wenn kaum Generalisierung betrieben wurde und die Software Lösung von speziellen Teilen nur so wimmelt. Weitere Wünsche führen nur zu weiterer Degeneration der Architektur.

Und was den dritten Punkt angeht: geringer Umfang des Software Projektes. Wer jemals z.B. mit C++ entwickelt hat wird festgestellt haben, dass eine Explosion des Codes sehr schnell eintritt und damit auch schnell zu langen Compile- und Linkzeiten führt.

Ein weiterer Grund für den Verzicht auf Generalisierung und Abstraktion ist darin zu suchen, dass neue Business Applikationen oft nur Frontends für bestehende Legacy Applikationen und Datenbanken sind. D.H. Letztlich wird nur das bestehende Datenmodell „objektifiziert". Daraus können natürlich nur sehr spezielle Klassen entstehen die kaum allgemein zu verarbeiten sind. Polymorphie kann dort gar nicht verwendet werden.

Diese Ansichten sind nicht unbedingt rein zufällig entstanden. Auf einem Arbeitskreis zu Framework Technologie wurde mir kürzlich versichert, dass gerade im Banken und Versicherungsbereich die Aufgabe der Objektmodellierung häufig von den ehemaligen Datenmodellierern erledigt wird.

Das zweite Verfahren mit automatischer Codegenerierung ist deutlich flexibler als das erste. Folgende Voraussetzungen müssen erfüllt sein, damit es erfolgreich ist:

Ich hatte die Gelegenheit an einem Projekt zur Verwaltung von Finanzinstrumenten für einige Wochen mitzuarbeiten. In diesem Projekt wurden die Instrumente mit Paradigm Plus modelliert und über selbstgeschriebene Scripts anschliessend Code erzeugt bzw. Mit existierenden Basisklassen gemischt. Die Businesslogik war ebenfalls in einer descriptiven Sprache erstellt und der Validierungscode generiert. Damit konnten sogar kurzfristige Änderungen im Standard der Finanzinstrumente in kurzer Zeit bewältigt werden.

Selbst ein Konzept zur Erweiterung des Systems konnte so entwickelt werden, dass die manuellern Anpassungen gering blieben. Eine Stelle die von der automatischen Generierung nicht erfasst wurde war das Java basierte GUI. Zwar waren die Finanzinstrumente einander strukturell sehr ähnlich (sie wurden sogar mehr oder weniger als Superset auf der Datenbank abgelegt) jedoch sollten sie dem jeweiligen Verfahrensstandard gemäss unterschiedlich dargestellt werden. Dies führte sehr schnell zu einem sehr fehlerträchtigen und mühsamen „cut and paste" Ansatz. Die GUI Teile der Finanzinstrument liessen sich auch nicht durch Ableitung wiederverwenden da die Ausschnitte (Views) nicht die gleiche Granularität der existierenden Attribute besassen, d.h. wenn eine Methode A einen set bestimmter Attribute zurückbrachte war das nur für eine Klasse B richtig, jedoch nicht für die inhaltlich sehr ähnliche Klasse C.

Das Mapping zwischen GUI Views und Modell Klassen musste also unter anderen Gesichtspunkten erfolgen als sie bei der Klassenmodellierung gültig waren.

Für dieses Problem bieten sich zwei Lösungsansätze:

Beide Verfahren setzen voraus dass der Verfahrensstandard der die Views letztlich bestimmt ebenfalls definiert bzw. Modelliert wird. Ist dies geschehen, können beide Verfahren eingesetzt werden.

Diesem eben geschilderten Schema folgt auch der von IBM kürzlich vorgestellte Component Broker. Auch dort werden mit OOA/OOD Tools Modelle (meist sog. „Business Objects") erstellt und durch ein inteaktives Tool (ObjectBuilder) mit einem mächtigen Framework verknüpft.

Vielleicht ist es eine Folge meines eher systemtechnischen Hintergrundes oder resultierend aus schlechten Erfahrungen mit den statischen Eigenschaften von C++ aber ich habe häufig ein schlechtes Gefühl bei einem derartigen Vorgehen und begründe es folgendermassen:

Der systemtechnische Aspekt von Software Lösungen wird meist nicht analysiert oder modelliert. Man konzentriert sich auf die „Business Objects", die wiederum häufig reine Mappings zu Datenbanktabellen sind, d.h. im wesentlichen aus „getter „ und „setter" Methoden bestehen.

Die Plazierung der Business Logik ist unklar: Soll sie in das Business Objekt oder als externer Verarbeitungsprozess funktionieren? Die Erfahrung zeigt, dass je mehr Business Logik in das jeweilige Objekt gelangt, desto weniger ist es für andere Verarbeitungsschritte geeignet. IBM spricht hier von „usage independent business logic" bleibt aber leider eine Definition dessen schuldig. Das Objekt verliert seinen Datencharakter. Die andere Alternative – externe Logik – stellt hingegen den Objektcharakter in Frage. Wozu brauche ich dann noch Business Objekte wenn die ganze Logik ohnehin nur durch externes Verarbeiten der Attribute des Objektes erfolgt? Zumindest hat dieses Verfahren den Vorteil dass es andere Workflows nicht grundsätzlich ausschliesst. Wartungsmässig ergeben sich jedoch gravierende Nachteile wie im nächsten Punkt deutlich wird:

Der Aufwand den Interface Änderungen für die Maintenance eines gesammten Geschäftsablaufs darstellen wird unterschätzt, dies ist eine Erfahrung gerade auch aus grossen CORBA Anwendungen [MAFF97],[MAWBR97]. Wenn das Systems 24 Stunden am Tag online sein muss, z.B. weil es international genutzt wird, dann ist die automatische Generierung nur noch ein theoretisches Mittel der Wartung und Erweiterung. Damit aber ein System zu Laufzeit dynamisch ausgewechselt oder erweitert werden kann braucht es enorme Unterstützung durch Systemklassen die wiederum Einfluss auf den generierten Code haben. Die IBM geht hier mit dem Component Broker sicher einen interessanen Weg, gelingt es ihr doch die Komplexität des Storage Managements praktisch vor dem Applikationsprogrammierer zu verstecken. Leider wird aber auch hier kein „hot swap" von Services geboten.

Wann besitzen dynamische Verfahren Vorteile?

wenn die Anzahl der Klassen grundsätzlich nicht begrenzbar ist (welche Typen von Dokumenten kann es z.B. geben?)

wenn zur Laufzeit Instanzen neuer und unbekannter Klassen verarbeitet werden müssen.

Wenn die Änderungen einen enormen Installationsaufwand nach sich ziehen.

Wenn ein Objekt sich nach aussen mit eingebautem Behavior zeigen soll (also im Sinne echter Objekte) dieses Verhalten aber dynamisch erstellt werden muss da es über die Laufzeit des Objektes wechselt bzw. das Objekt immer neuen und teils noch unbekannten Verarbeitungen unterzogen werden muss.

Gut denkbar sind auch Mischformen von generischen und generativen Verfahren. Z.B. kann das Objektmodell durch Scripts auch in ein Metamodell überführt und zur Laufzeit zur Verfügung gestellt werden. Leider habe ich noch kaum Modellierungen solcher System gesehen.

Noch ein kleiner Nachtrag zur GUI Problematik: Wie können Views auf Klassen gemappt werden?

Typischerweise verwendet man einen sog. GUI-Builder zum Aufbau von Bildschirm Masken und Layouts. Während es keine Frage ist dass das manuelle Arrangieren von Feldern ohne ein Layout Tool recht mühsam ist ergeben sich beim näheren Hinsehen doch einige kritische Punkte.

Woher weiss der Layout Designer was für GUI Elemente er selektieren muss? Es muss dafür irgendeine Spezifikation geben. Wenn es sie gibt, warum wird sie nicht zur Generierung verwendet? Gibt es Gemeinsamkeiten der Views bzw. treten einzelne Views immer wieder auf? Wenn ja, können sie an beliebigen Stellen so referenziert werden ohne dass Verdoppelungen auftreten? Können einzelne Views voneinander erben? Wenn eine Änderung der View Vorschrift auftritt, müssen alle Ressource Files geändert werden? Und wenn, geschieht dies manuell? An einer zentralen Stelle? Woher weiss der Layout Designer wie lang Felder sein müssen? Tritt hier nicht eine Verdoppelung von Information auf, denn andere Stellen im System müssen das auch wissen?Wie kann es sein dass ich ein komplexes Layout mit einem Texteditor sehr einfach und schnell massiv abändern kann (vorausgesetzt das Ressource File ist editierbar) mit dem Layout Tool selbst aber mühsam alle Felder einzeln manipulieren muss? Kann es sein dass der GUI gesteuert Zugriff doch nicht immer der optimale ist?

Kurz und gut, dies sind nur einige ketzerische Fragen an die übliche Auffassung, dass das GUI eine Applikation „treibt". Mir scheint die Vorstellung von generischen Browsern wesentlich angenehmer, ganz im Sinne von Netscapes Devise „the information is the interface". Ähnliche Fragen lassen sich übrigens auch an einen Datenbank Designer richten. Sie betreffen letztlich den Unterschied zwischen der „Informationsarchitektur" und der „Implementationsarchitektur" [BIRMAN96] eines Systems, auf den weiter unten noch genauer eingegangen wird.

Natürlich ist nicht alles ein Dokument, genausowenig wie das Web alle EDV-Probleme lösen wird. Es ist jedoch erstaunlich, wie weit eine so allgemeine Metapher wie „Dokument" tragen kann.

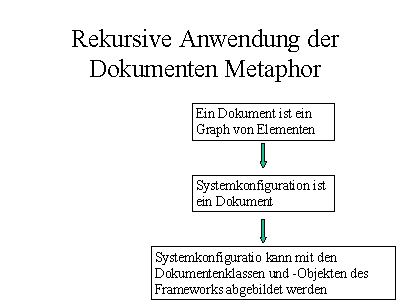

Die anfänglich nur zaghaft eingeführte Abstraktion „Dokument" für die Kernobjekte des Systems wurde nun auch auf andere Bereiche als wie die ursprünglichen „Belege" ausgeweitet.

Was ist ein Dokument? Ein dynamisch zusammengebautes Objekt, bestehend aus vielen anderen. Die Art und Weise der Zusammensetzung regelt wiederum ein Dokument.Was ist Systemkonfiguration? Ein Dokument. Was ist Workflow? – Eine Beschreibung, d.h. ein Dokument. Was ist Datenimport? – Eine Transformation eines Dokumentes in ein anderes, vermittelt über eine Beschreibung (Dokument) der notwendigen Abbildungen. Was ist eine Data-Management Komponente? Ein System das Dokumente persistent speichern kann, in Formaten die in Meta-Dokumenten festgehalten sind. Was ist ein View? Die dynamische Darstellung von Dokumenten mit Hilfe von Beschreibungen (Style-Sheets, View-Descriptions)

Durch die entstandene Vielfalt von Anwendungsmöglichkeiten des Dokumentenbegriff wurde plötzlich auch eine Kernaussage der Taligent Entwickler verständlich: zentrale Metaphern müssen sehr allgemein sein, z.B. People, Places, Things. Nur diese Allgemeinheit lässt einen unscharfen und damit vielfältigen Gebrauch zu. Vielleicht hat Wittgenstein mit seiner Definition der Bedeutung von Begriffen durch ihren Gebrauch doch etwas Richtiges getroffen.

Die vielfältige Verwendung des Dokumentenbegriffes hatte enorme Konsequenzen für die Implementation. Dieselben Dokumentenklassen konnten in immer neuen Zusammenhängen wiederverwendet werden. Die Entwickler gewöhnten sich schnell and die relativ überschaubare Zahl von Klassen und Methoden. Die Komposition der Dokumente konnte ebenfalls in anpassbare Klassen ausgelagert werden.

Eine weiter Erkenntnis war, dass in grossen Systemen das Verhalten der Klassen hinter die Bedeutung der Informationsarchitektur, d.h. der Daten (Dokumente) und der Metadokument zurücktritt.

Die vielleicht wichtigste Entscheidung war jedoch, das Dokumentenmodell auf das Framework selbst anzuwenden, d.h. viele Informationen die früher hart codiert im Source Code gelandet wären wurden nun als Dokumente extern gehalten und zur Laufzeit geladen und interpretiert. Flexibilität und vor allem Klarheit der Architektur wurden damit wesentlich verbessert.

Eine Anmerkung zu den sozialen Konsequenzen dieses Vorgehens: Die Durchführung der radikalen Abstraktion führte zum Bruch mit der ausschliesslich aus Mathematikern bestehenden Gruppe der Applikationsentwickler.

Nach den vernichtenden Ergebnissen des Protoypen entschied sich das NEWSYS Team auf ein Framework Design umzusteigen. Zum damaligen Zeitpunkt gab es praktisch keine verfügbaren Frameworks die man hätte kaufen können.

Die Geschäftsleitung lehnte den sofortigen Einsatz von CORBA (Orbix) ab (zu teuer, Zeitaufwand bei Einarbeitung, zunächst kein distributed computing geplant). In der Folge mussten vom NEWSYS Team wesentliche Broker-Mechanismen selbst implementiert werden. Grob geschätzt gingen in einem Zeitraum von 12 Monaten 80% der Zeit in die Grundlagenentwicklung.

Zur objektorientierten Applikationsprogrammierung ist eine Systembasis nötig, die in C++ nicht vorhanden ist. Lebenswichtige Services müssen entweder selbst entwickelt oder eingekauft werden. 80% der Arbeiten im ersten Jahr sind Grundlagen Technologien.

Eine überraschende Erkenntnis nach der Analyse der physischen Eigenschaften von C++ war, dass die Trennung von Interfaces und Implementationen ein Broker Konzept erzwingt, AUCH wenn die Applikation nur lokal laufen soll.

Zum Zeitpunkt der Entscheidung gab es keinerlei Erfahrung über die Zeitdauer einer Framework Entwicklung. Von Seiten der Applikationsgruppen kam Widerstand, da dort ein Toolkit mit feststehendem API erwartet wurde. Das NEWSYS Team stand somit vor dem Problem, dass einerseits (Geschäftsleitung) ein sehr flexibles System erwartet wurde, andererseits (Applikationsgruppen) ein festes API mit festen Implementationen vorausgesetzt wurde. Hinzu kam, dass die Grundprobleme von C++ (statisches Linken, keine Interfaces) nur schwer vermittelbar waren.

Hohe Kompetenz von Applikationsentwicklern hilft wenig beim Kampf mit Systemstrukturen der Applikation bzw. der Programmiersprache. Lifecycle Betrachtungen sind ebenfalls oft ein fremdes Konzept.

In der Folge stellte sich auch heraus, dass der zentrale Gedanke eines Frameworks: neue Funktionalität durch das Austauschen von „Puzzleteilen" zu erreichen von den Applikationsgruppen nicht mitgetragen wurde. Für die NEWSYS Gruppe war das Framework in erster Linie ein funktionaler Rahmen der Erweiterbarkeit mit bewussten Leerstellen. Für die Applikationsgruppen waren die Leerstellen nicht Möglichkeiten der Erweiterung sondern einfach mangelnde Funktionalität. Dieser Konflikt endete damit, dass die Mitglieder der Framework Entwicklung auch die Applikationen auf Basis des Frameworks entwickelten. Es hatte sich eine unüberbrückbare technische, sprachliche und kulturelle Kluft ergeben.

Ein in diesem Zusammenhang immer wieder aufgeführtes Argument war das des „Pragmatismus". Abstraktionen oder Reengineering wurde abgelehnt mit dem Hinweis, man sei ja „Pragmatiker". Im Laufe der Zeit wurde klar, dass damit eigentlich etwas ganz anderes gemeint war:

Pragmatismus in Software Projekten wird oft als Ausblenden der Lifecycle Problematiken verstanden. Wenn überhaupt Probleme erkannt werden (Softwäre wächst, Wartung und Installation) werden sie nach hinten verschoben.

Beispiel:

Die meisten „alten" Mitarbeiter neigten zu sehr langen Methodenrümpfen. Häufig versuchten sie lediglich bestehenden Code in neuen Klassen wiederzuverwenden. Restrukturierung und Faktorisierung des Codes wurde abgelehnt. Derartige Klassen sind nicht wiederverwendbar und nur schwer zu warten.

Sehr lange Methodenrümpfe sind ein typisches Kennzeichen von ehemaligen C Programmierern die versuchen, alten Code und alte Methodik im OO-Bereich weiter zu verwenden. Diese Methoden machen Klassen nicht wiederverwendbar und können nur global überschrieben werden. Die Methodenlänge ist durchaus als empirisches Kennzeichen des OO-Entwicklungsstandes im Projektmanagement verwendbar.

In einem mehr oder weniger bewussten Prozess entstand in den Monaten nach dem Prototypen ein Framework. Die weiter unten beschriebenen Strukturen sind eine Sichtweise aus dem Nachhinein!

Viele zentrale Design Pattern wurden aus FRESCO [LINTON] übernommen. Das Ergebnis ein Framework das das logische Modell der Trennung in verschieden Domains um weitere Dimensionen (im folgenden „Strukturen") erweiterte.

Ein Framework ist die Realisierung (im Sinne der UML 1.0) einer „Evolving System" Meta Architektur, die ein Produkt in seinem ganzen Lebenszyklus (Entwurf, Entwicklung, Erweiterung und Spezialisierung, QA, Installation, Konfiguration, Kunden, Wartung etc.) betrachtet. Diese Architektur ist das krasse Gegenteil einer „pragmatischen" Sichtweise, die vor den unvermeidlichen Änderungen eines Systems die Augen verschliesst.

Im Prozess der Realisierung eines Frameworks hebt sich die Trennung zwischen Applikationsentwicklung und Grundlagenentwicklung auf. Mitglieder eines Frameworkteams müssen während der Arbeit umschalten können. Dies stösst bei manchen auf grosse Probleme im Selbstverständnis.

Es wurde bereits erwähnt, dass object creation einer der gravierendsten cold spots eines Systems ist. Dies erklärt sich dadurch, dass im Moment der Instanziierung mehrere Strukturen des Frameworks gleichzeitig beteiligt sind:

Cold Spot Analyse ist die Untersuchung eines Mechanismus daraufhin, welche Teile davon so festgelegt sind, dass sie OHNE Source Code Änderung nicht modifiziert werden können und worin diese Abhängigkeiten bestehen. Cold Spot Analyse verändert das WER, WANN, WELCHE und WIE und untersucht die Konsequenzen auf die logische, physische, runtime und extension sowie die Sourcecode-Struktur.

Wem die folgende Analyse übertrieben erscheint, hat noch nie eine grössere OO- Applikation mit C++ entwickelt.

Ausserhalb eines Framework Konzeptes entsteht bei der Arbeit mit C++ schnell eine fast paranoide Furcht vor Änderungen. Notwendige Verbesserungen im Design unterbleiben weil sie Auswirkungen auf viele Stellen des Source Codes hätten und ausserdem eine Reinstallation erzwingen würden.

Beispiel: Object creation cold spots und ihre strukturelle Dekomposition

X.hpp/cpp

#include <Z.hpp>

#include <Y.hpp>

#include <G.hpp>

Class X {

private:

G myG;

Y myY;

public:

DoIt () {

Z myZ = new Z();

..}

}

Eine multidimensionale Dekomposition zeigt, dass dieses harmlos aussehende Stückchen Source Code MEHRERE cold spots enthält, die verschiedene Strukturen betreffen, z.B.:

Einen physischen cold spot der erzwingt, dass X recompiliert werden muss wann immer etwas im Headerfile von G, Z oder Y geändert wird. D.H. auch bei der Einführung einer neuen privaten Variablen die den Client X überhaupt nicht interessiert da er sie ohnehin nicht erreichen kann. Wenn G, Z oder Y im .cpp geändert werden, muss der Client X neu gelinkt werden, da sich Adressen verschoben haben können.

Mehrere logische cold spots: Ohne Sourcecode Änderung ist es nicht möglich in X ein abgeleitetes Z‘ oder Y‘ zu verwenden. Es ist nicht möglich X als composite object zu behandeln das beliebige child implementations desselben Interfaces enthalten kann. Y ist ein festes Member von X. Es können nicht mehrere Y verwendet werden.

Einen cold spot bezüglich der Erweiterungsstruktur: Wenn ein bugfix für X,Y oder Z nötig wird, wird gleichzeitig ein neues Release nötig da alle Klassen miteinander verbunden sind. Die Klassen werden auch nicht distributed laufen können.

Einen sozialen cold spot: Die Klassennamen unterliegen keiner Konvention und geben keinerlei Hinweise auf die Eigenschaften der Klassen (Sind es Interfaces, default implementations, konkrete Klassen die nicht mehr abgeleitet werden sollten? Multiple Inheritance Klassen mit Besonderheiten bei Pointern?) Die Integration neuer Teammitglieder wird erschwert, zumal auch keinerlei Design Patterns erwähnt sind. Class members sind nicht deutlich unterschieden von automatic variables.

Ein cold spot bezüglich der Wartung und Auslieferung: Es gibt keine Unterstützung für automatisches Generieren einer Class Reference direkt aus dem Source Code.

Ein cold spot bezüglich der Sourcecode Struktur: Diese Stück Sourcecode ist NICHT portabel. Microsoft Plattformen brauchen z.B. spezielle calling declarations (declspec) die mit Macros gekapselt werden müssen. Andere Plattformen und Compiler brauchen möglicherweise andere Anweisungen.

Ein cold spot bezüglich des build Prozesses und der Source Code Struktur. Es gibt keine Macros vor der Declaration, in der Declaration und im Implementationsteil dieser Klasse. D.H. man kann keine neuen Methoden oder Funktionen automatisch einfügen durch Änderung eines Macros. Gerade Basisfunktionalität muss aber häufig „nachgerüstet" werden weil man sie am Anfang nicht gekannt oder verstanden hat.

Ein runtime cold spot: Es wird keine Metainformation zur Klasse generiert (Name, Ableitung etc.)

Ein cold spot bezüglich Quality Assurance: memory deallocation ist nicht spezifiziert, es werden keine Smartpointer eingesetzt. Dies ist besonders schlecht im Falle von Exceptions.

C++ unterstützt das Konzept sich entwickelnder Systeme nur ganz gering. Mit wenigen Statements werden physische Abhängigkeiten geschaffen ohne dass dies sofort bemerkt wird. Low Level Implementationsdetails der Programmiersprache beeinflussen das Applikationsdesign. Der ohnehin recht statische Charakter von Klassifizierungsystemen (und nichts anderen sind Klassenhierarchien) wird durch die Programmiersprache noch verstärkt.

Das nächste Beispiel zeigt einen typischen Framework Code in C++. Der Code versucht die eben angesprochenen Probleme zu umgehen.

SyPNContainerDoc.hpp/cpp

// Copyright, usage

// RCSid etc.

// InterfaceVersionID ALL automically generated!!!!!!!!!!!!!!!!!!!!!!!!!

#ifndef SYVDSTORAGEMANAGER_HPP

#include <SyVDStorageManager.hpp> // Storage Manager Interface from Data management Domain

#endif // include protection, reduces build time, generated automatically

#ifndef SYVPDOCPART_HPP

#include <SyVPDocPart.hpp> // Document Part Interface from Problem Domain

#endif

DeclareNormalImplementationClass(SyPNContainerDoc) // macro for reference types and

// smart pointers, declares an implementation for

// a Systor Interface

// the class declaration is a macro that sets platform dependent export/import statements

// depending on the PACKAGE declaration (SBV_Customer is set during build).

// The macro also generates meta class information.

// the comment uses a tag for automatic class reference generation

//- SyPNContainer

SyNClass1(SyPNContainerDoc, SyVPDocPart, SBV_Customer)t

//. This class provides a simple container for document

//. Parts .......

//. Design Patterns: composite object

//. preconditions, postconditions, warnings

{ // this macro will cover anything that is necessary in class declaration (e.g.

// class meta information etc.

NormalImplementationInDeclaration(SyPNContainerDoc)

public addChild(SyVPDocPart_ref) { } Any document part can become a member now, not just Y

doIt () {

// use configuration to find which class to use (could be a pattern for a trader too)

String_ref StorageManagerName = (Broker->lookup(„StorageManager");

// use Broker to get factory to get StorageManager. ONLY interfaces are known by X!

// use tmp macro to count down ref count on returned temporaries

SyVDStorageManager_ref = _tmp(Broker->DMCKit())->StorageManager(StorageManagerName);

..}

private:

G myG; // This is OK if and ONLY if G is declared and implemented IN THE SAME

// physical package as this source file!!!!! (component level insulation)

}

Das Beispiel sieht zunächst ziemlich kompliziert aus allerdings können die meisten Statements automatisch generiert werden. Wesentlich ist die „Künstlichkeit" des Source Codes, die aus der Anwendung von Coding Conventions stammt, die die Trennung der physischen Strukturen sicherstellen.

Die Klasse X (SyNPContainerDoc) kennt jetzt ausschliesslich Interface Klassen.

Sämtliche beteiligten Implementationen könnten zur Laufzeit ausgetauscht werden

Der Client kennt noch nicht einmal den konkreten Klassennamen z.B. des StorageManagers. Er erhält ihn aus einer Konfiguration bzw. als Default aus der DMC factory

Der Code is plattformunabhängig (export/import Statements werden über einen Macro gesetzt, Funktionen zum dynamischen Laden, sog. „Loader Functions" fehlen allerding noch).

Der Container part kann jetzt beliebige andere Dokument Parts aufnehmen.

Der Source Code entspricht automatisch Richtlinien NEWSYS und wird als template automatisch generiert.

Meta Information wird automatisch generiert. Weitere Methode die alle Implementations von Interfaces betreffen können automatisch eingefügt werden, z.B. Loader Functions zum Laden aus DLLs.

Der Client X muss nur noch compiliert oder gelinkt werden, wenn sich das Interface der verwendeten Klassen ändert. Das Composite Object Pattern sorgt dafür, dass dies selten der Fall ist.

C++ Code innerhalb eines Frameworks stützt sich stark auf generative Mechanismen, oft als Macros implementiert. Der Code ist hoch ritualisiert und geregelt. Die Entwickler müssen durch kleine Tools unterstützt werden. (NEWSYS beinhaltete z.B. einen Source Code Generator der Templates von Header Files, Implementations Files, Funktionen oder Applikationen erstellte).

Ein C++ Framework braucht umfangreiche Coding Standards die NICHTS mit der Optik des Source Codes zu tun haben. Die Coding Standards beinhalten das gesammelte Design Wissen des Framework Teams. Fremde Benutzer MÜSSEN diese Standards ebenfalls einhalten.

Die tatsächliche Komplexität der dahinterliegenden Macros und Mechanismen wird nicht sichtbar, ihre Kenntniss ist aber auch durch Tools nicht ersetzbar. Programmierer brauchen tiefe System- und Plattformkenntnisse.

Zur Bedeutung von Coding Standards siehe Kapitel Coding Standards.

Bevor in den folgenden Abschnitten die Strukturen eines Frameworks im Einzelnen behandelt werden hier noch das Beispiel von oben als Java Source:

/* SyPNContainerDoc.java

* Copyright, usage

* RCSid etc.

*/

package systor.doc.Implementations

import java.*

import systor.doc.* // document interfaces

import systor.broker.* // broker and factory interfaces

/**

*implements a container part for systor document parts by extending the interface class for document parts

*This class provides a simple container for document Parts

* Design Patterns: composite object

* preconditions, postconditions, warnings

*/

class SyPNContainerDoc implements SyPVDocPart

{

/**

* any doc part type can be added to this container doc part

*/

public addChild(SyVPDocPart) { }

/**

*method uses configuration information and broker and storage manager interfaces

*in a generic way.

*/

public doIt () {

String StorageManagerName = Broker->lookup(„StorageManager");

SyVDStorageManager myMngr = Broker->DMCKit()->storageManager(StorageManagerName);

..}

private G myG();

// a version identifier for evolving classes, see java serialization ap.

// generated by a serialver (do not confuse with source code id!):

static final long serialVersionUID = 1234567890123456L;

}

Dieser Java Source Code sieht weniger kompliziert aus als die C++ Version. Er enthält jedoch MEHR Funktionalität (eingebaute automatische Dokumentation, garbage collection) und hat durch das dynamische Linken nicht das Problem der „fragile superclass" bei dem nachträgliche Änderungen an Basisklassen umfangreiches Recompilieren und Linken aller abgeleiteteten Klassen erzwingt.

Bei Interface Änderungen sind die turn around Zeiten DRASTISCH kürzer als im C++ Fall, etwas das das verbesserte C++ Beispiel oben noch gar nicht berücksichtigt.

Die Mechanismen dahinter die der Programmierer verstehen muss sehen nicht nur weniger kompliziert aus, sie sind es auch. Mit anderen Worten: Die Integration von Teammitgliedern wird schneller gehen.

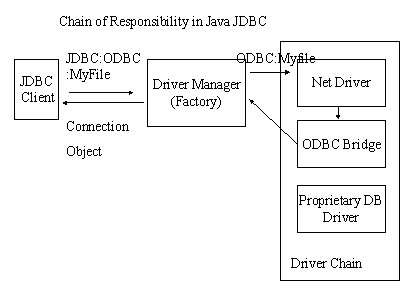

Noch wichtiger als die physischen Aspekte der Programmiersprachen ist jedoch die folgende Erkenntnis: Die Design Patterns „Broker" und „Factory" sind in Java nicht weniger wichtig als in C++. Sie sind nur leichter zu erzeugen und zu warten. Durch die weniger komplexe physische Struktur erlaubt es Java sich auf die logischen Strukturen und Design Patterns zu konzentrieren.

In diesem Fall bedeutet dies: Der Client braucht nicht die Implementation der Objekte zu kennen, mit denen er arbeitet. Kunden können Klassen spezialisieren und der Client wird ohne Änderung mit den neuen Klassen arbeiten können. Dieselben Pattern erreichen das gleiche Ziel in C++, nur dass sie dort noch zusätzliche Sprachprobleme lösen.

In Java ist die Behandlung physischer Eigenschaften leichter. Die logischen Strukturen, z.B. das Verstecken von spezifischen Objektimplementationen hinter Broker und Factories bleiben gleich. Die hot spots die ein Evolving System braucht werden durch die gleichen Design Patterns wie in C++ erzeugt. Braucht es noch mehr Gründe für einen an Design pattern orientierten Entwicklungsprozess?

Als ich noch ein blutiger Anfänger in der Unix Kernel Division der Siemens AG war und Device Treiber für die damals neuen Multiprozessor Systeme entwickelte, habe ich einmal einen sehr erfahrenen Freund bei Sequent gefragt, was man ein Multiprozessor System baut. Seine Antwort lautete: „Das ist ganz einfach, man muss nur alle globalen oder statischen Variablen mit Locks vor gleichzeitigen Zugriffen schützen." Die Kunst besteht natürlich darin, dies mit Hilfe von spezieller Hardware und geschickten optimierten Algorithmen so zu tun dass n Prozessoren auch ungefähr die n-fache Systemleistung erbringen.

Analog dazu bring Ken Birman distributed computing auf einen Punkt: es ist eigentlich trivial. Das Problem liegt nur darin auf zwangsläufig auftretende Fehler (Hardware,Software,Bedienung) so zu reagieren, dass Reliability und Security gesichert sind und die Performance noch akzeptabel bleibt.

In diesem Sinne definiere ich ein „Frameworking" als das Berücksichtigen aller Abhängigkeiten innerhalb eines Softwaresystems über den gesammten Lebenszyklus hinweg. Die Aufgabe besteht darin, diese Abhängigkeiten und deren Konsequenzen zu erkennen und Techniken zu entwickeln, die ein Degenerieren des Systems verhindern. Und die Kunst ist es, trotzdem in erträglicher Zeit zu einem Produkt zu kommen.

Deshalb geht der nachfolgende Teil genau auf die technischen Strukturen und ihre Verbindungen ein und versucht praktische Lösungen anzubieten.

Die Definition eines Frameworks ist noch nicht vollständig. Birmam (wie viele andere) hebt noch etwas entscheidendes hervor: Den Willen, z.B. Probleme der Reliability und Security ernst zu nehmen und technisch zu lösen. Er zeigt eindrucksvoll dass wir Softwareentwicklung auf gut Glück betreiben und hoffen dass unsere Programme keine Menschen umbringen. Eben dieser Wille scheint neben der Technik die zentrale Rolle zu spielen, wie auch im Falle von NEWSYS.

Die Erfahrungen im NEWSYS Projekt haben gezeigt, dass der Wille u.a. von 2 Faktoren abhängt:

Im Anschluss an die Behandlung der technischen Strukturen eines Frameworks wird daher auf die sozialen Strukturen eingegangen, die seinen Erfolg wesentlich mitbestimmen. Darüberhinaus versuche ich zu zeigen, dass zwischen technischen und sozialen Strukturen eine enge gegenseitige Abhängigkeit besteht und wie man sie günstig beeinflussen kann.

Der Titel „Frameworking" wurde von mir ganz bewusst gewählt um die Arbeit an einem Framework als technischen und sozialen Prozess hervorzuheben.

Natürlich hat Frameworking noch weitere Dimensionen. Neben der technischen und sozialen Dimension steht der Produktionsprozess von Software in einem Mikroökonomischen und einen Makroökonomischen Zusammenhang. Die mikroökonomische Dimension habe ich (vielleicht als Folge der Tatsache dass NEWSYS innerhalb einer kleinen Firma entwickelt wurde in der soziales und ökonomisches hautnah miteinander verbunden sind) einfach unter den sozialen Strukturen mit behandelt. Die Makroökonomische Dimension (hier geht es u.a. um die Frage wie lange sich Softwareentwicklung noch ausserhalb normaler Geschäftsbedingungen abspielen kann? Stichwort: Produkthaftung, Gewährleistung, Qualität, Sicherheit etc.) übersteigt jedoch meine Kompetenz bei weitem und sprengt den Rahmen des Papers, das auf praktische Hilfen beim Frameworking ausgerichtet ist. Meiner Meinung wird jedoch der Tag kommen an dem ein US Gericht die Absicherungsklauseln eines Softwarherstellers für ungültig erklärt und Schadensersatz in enormer Höhe zuspricht. Von diesem Tag an wird „Frameworking" nicht mehr nur nützlich und praktisch für den internen Produktionsprozess sondern eine absolute Notwendigkeit sein.

Die hier gegebene Definition von „Frameworking" vermeidet absichtlich eine Bindung an Objekttechnologie. Zwar wurde NEWSYS unter Verwendung von Objekttechnologie entwickelt und deshalb liegt der Schwerpunkt des Papers auch darauf, aber dies ist keine notwendige Voraussetzung für ein Framework. Viele Operating Systems sind z.B. Nicht-OO Frameworks (Device Driver, pluggable Filesystems, Policies für User/Security, streamsbasierte protocol stacks etc. sind alles Puzzleteile und entsprechen dem Lifecycle Aspekt eines Frameworks)

Ausserdem, und dies ist eine persönlich gefärbte Aussage, habe ich nach wie vor Probleme mit Klassifikationssystemen. Sie sind immer unter gewissen Blickwinkeln und Annahmen entstanden. Und während sie sich im Alltag praktisch einsetzen lassen (und auch notfalls abändern) erweisen sich bisher objektorientierte Systeme beim Wechsel von Perspektiven als sehr unflexibel. Änderungen der Klassifikationen sind aufwendige Massnahmen. Hingegen sind strukturelle Transformationen z.B. von ausgezeichneten (mit Metainformation versehenen) Informationen/Daten relativ leicht und automatisch machbar. In einer Zeit wo sich Organisationen laufend umstrukturieren, d.h. ihre internen Klassifikationssysteme umbauen und flexibler gestalten ist eine Software auf Basis von starren Klassifikationssystemen problematisch.

Beispiel: Class Customer

Wenige Entwickler von Business-Software zögern eine Klasse „Customer" zu definieren. Mit etwas Glück erkennen sie rechtzeitig, dass die Klasse Customer besser nicht von der Klasse Person abgeleitet wird, da es juristische Personen als Customer gibt. [FOWLER] Aber wie sieht es mit dem ontologischen Gehalt von Customer aus? Customer sieht wie eine Basisklasse aus – ein sog. Business Object. In Wirklichkeit handelt es sich bei Customer bereits um eine Relation zwischen anderen Entitäten. Diese Relation kann sich mit der Zeit verändern. Neue Aspekte kommen hinzu. Eventuell wird aus einem Customer ein Partner oder ein Teil der eigenen Firma.

Momentan zeichnet sich ausserdem durch die Agent-Technologie ein Trend ab, der mehr die Kapselung und „Lebendigkeit" eines Objektes betont als die Position innerhalb einer Klassifikation. Unübersehbar ist auch der Trend in Richtung mehr Metainformation, sei es bei Objektdatenbanken oder beim Austausch zwischen Komponenten (Java‘s Infobus z.B. tauscht Daten aus).

Table of Contents

Ich weiss es nicht. Momentan glaube ich, dass Strukturen ein Konstrukt unseres Verstandes sind und dass Entities der Realität Hinweise sind nach Strukturen zu suchen, sie zu konstruieren.

Es gibt einige Belege dafür: Strukturen, speziell software Strukturen sind unsichtbar. Wenn sie es nicht mehr sind dann entweder weil sie jemand im Source Code visuell ausgezeichnet, „getaggt" hat oder weil wir mittlerweile Erfahrung gewonnen haben die es uns gestattet, anhand von Source Code Stücken sofort davon betroffene Strukturen zu erkennen.

In bezug auf Strukturen in Frameworks haben wir folgende Situation:

Framework Strukturen sind:

Wie wir an den Source Beispielen oben gesehen haben, kann ein einziges Statement zu mehreren Strukturen gleichzeitig gehören ohne dass irgendetwas in diesem Statement auf diese Tatsache hinweisen würde. Mit einem Statement kann man seine sorgfältig entworfenen logischen Abstraktionen korrumpieren, die aufwendig kreierten physischen Trennungen ruinieren und Erweiterbarkeit und Wartung schwer einschränken.

Zumindest in ihren Konsequenzen sind Software Strukturen real.

Der härteste Teil bei der Behandlung von Software Strukturen in Frameworks ist, sensitiv für die Hinweise in Source Codes zu werden die anzeigen, dass bestimmte Strukturen davon betroffen sein könnten. Object Creation statements sind ein Beispiel dafür. Include Files ein anderes.

Und wenn man diese Hinweise entdeckt hat ist es wichtig deutlich zu machen, zu welchen Strukturen sie gehören und sie entsprechend auszuzeichnen, zu markieren. Coding Standards mit Regeln für Namensgebung etc. sind ein Platz dafür. Sonst werden Neulinge sie nicht wahrnehmen.

Und wenn wir das alles getan haben, kommt das nächste Problem: Sind diese Strukturen miteinander verknüpft und wie kann man dies visualisieren?

Es ist nicht schwer zu zeigen, dass Strukturen in Frameworks miteinander verknüpft sind:

Moderne Software muss reflektiv sein, mit anderen Worten, sie muss über sich selbst Auskunft geben können. Ein Teil der dazu notwendigen Information entsteht während des Build Prozesses, z.B. über package und Komponentennamen, Versionen, Interface Versionen etc. Die Build Struktur muss diese Informationen gewinnen und sie zurück in die Source Struktur leiten (z.B. über compiler defines). Elemente der logischen Struktur werden zur Laufzeit von der Runtime Struktur benutzt um diese Informationen zu verarbeiten, z.B. auf Interface mismatches hinzuweisen. Wenn das Framework selbst zur Laufzeit neue Klassen generieren soll, wird die Verbindung zur Source Struktur noch enger.

Die schwere Frage ist nochmals: Wie erklären und zeigen wir diese Verbindungen und Abhängigkeiten?

Framework Strukturen geben uns 3 Probleme zu lösen:

Einige der wichtigsten technischen Strukturen eines Frameworks sind:

Theoretisch könnten alle verschieden Strukturaspekte in einem einzigen Objekt Modul (file) zusammengefaßt werden. Erweiterungen (kundenspezifische, branchenspezifische oder einfache Fehlerbehebungen würden in diesem File stattfinden. Danach würde neu kompiliert und gelinkt und ein neues Release wäre fertig.

Dies ist bereits bei der Verwendung von C nicht praktisch und C++ stellt darüber hinaus besondere Anforderungen an die physische Struktur.

Die physische Struktur von grösseren C++ Paketen hat wiederum Einfluß auf die logische Struktur, was sich z.B. in besonderen Designtechniken wie Interface/Implementation Trennung oder bestimmten Hilfsklassen wie Factories und Brokern zeigt.

Bezeichnend ist, dass zwischen den einzelnen Strukturen Abhängigkeiten bestehen. Z.B. Sollten die Elemente der physischen Struktur ebenfalls als Klassen modelliert (reflektiert) werden. Dies setzt jedoch Input von der Source Struktur voraus.

Die Komplexität der analytischen Struktur hängt von der Zielrichtung des Frameworks ab. Hier kann man unterscheiden zwischen erweiterbaren und generischen Frameworks.

Erweiterbare Frameworks lassen in ihren Strukturen Leerstellen, die Anwender durch Einfügen der fehlenden Stellen für ihre Zwecke spezialisieren können. Hier ist das Framework EINFACH, die Arbeit der Anwender üblicherweise relativ komplex.

Der Abstraktionsgrad ist noch nicht sehr hoch, d.h. der Gegenstandsbereich wird teilweise direkt in der Maschine abgebildet. Neue Typen des Gegenstandsbereichs erfordern oft neue Verarbeitungsobjekte im User Interface, im Datenbank Management etc. Dynamische Casts zur Behandlung spezieller Objekte sind teilweise nötig.

Typischerweise gibt es keine Meta Infomationsmodelle. Der Anteil wirklich generischer Module, d.h. Module die einen grossen Gegenstandsbereich ohne extra Anpassung verarbeiten können ist gering. Damit hat die analytische Struktur grossen Einfluss auf die physische und extension Struktur.

A simple Framework based on the puzzle metaphor with hot spots for customization

Erweiterbare Frameworks werden durch die Puzzle Metapher gut beschrieben. Zur Laufzeit sind sie Instanzen spezieller Applikationen. Die analytische Struktur eines erweiterbaren Frameworks leistet im wesentlichen eine „hot spot" Analyse auf Objektlevel.

Genau das Konzept der Flexibilität auf Objektlevel ist jedoch auch die grösste Schwäche des Puzzle-Modells. Wie das Diagramm zeigt, spaltet sich ein Objekt in die verschiedensten Aspekte auf und betrifft ganz unterschiedliche Strukturen. Das Puzzle-Modell funktioniert nur, wenn der Aspekt den das Objekt ausdrückt auf logischer Ebene GENAU LOKALISIERBAR ist. Dies ist typischerweise der Fall in Sub-Frameworks wie z.B. einem Converter Framework Die Unterstützung eines neuen Text Formates ist eines der Paradebeispiele für „Plug and Play" durch Objektaustausch. Anwendungen im Source Code dazu finden sich im ET++ und MET++ Framework [ACKERMANN]

Generische Frameworks sind in ihrem Aufbau sehr KOMPLEX, erlauben aber das einfache Behandeln einer grossen Zahl unterschiedlicher Gegenstände. Sie sind generische Maschinen zur Bearbeitung von Gegenständen der Realität. Eine solche Maschine setzt einen hohen Grad an Abstraktion des Gegenstandsbereiches voraus. Die analytische Struktur muss diese Abstraktionen liefern.

Innerhalb der analytischen Struktur findet eine Dekomposition der Gegenstände der Realität in Grundstrukturen statt. Das Framework arbeitet auf diesen Grundstrukturen. Es gibt in einem Framework nichts was z.B. direkt einem bestimmten Dokument Objekt entsprechen würde. Es gibt keine direkte Entsprechung zu einem speziellen Use Case.

Als generische Maschine kann ein Framework keinen konkret auf spezielle Gegenstände bezogenen Code beinhalten. Überhaupt ist es nicht gut in Framework Code direkt Gegenstände der Realität abzubilden. Es gibt im allgemeinen kein singuläres Programmobjekt das einem Objekt der Realität entsprechen würde (schlicht deshalb weil die Objekttechnologie bisher in keinster Weise echte Objekte abbilden kann und ihnen zudem die ontologische Qualität (noch) fehlt). Als Folge dessen ist auch ein dynamisches Casten meist nicht sinnvoll – WORAUF SOLLTE DENN GEKASTET WERDEN wenn es keine 1:1 Entsprechungen gibt?

Generische Frameworks bestehen aus generischen Modulen die Verarbeitungsanweisungen nicht im Source Code einprogrammiert haben sondern aus Meta Informationen beziehen. Gegenstände der Realität sind in Form von Metamodellen beschrieben auf denen alle Module des Frameworks zugriff haben. Diese Metamodelle sind üblicherweise selbstbeschreibend.

Zur Laufzeit erfolgt im Framework eine Umsetung der Meta Informationen in Cluster und Bäume aus konkreten Programmierobjekten des Frameworks. Der Unterschied zwischen Meta Information als Abbildung der Realität und dessen Umsetzung in Programmobjekte bleibt deutlich sichtbar.

Ein Beispiel:

Es gibt ein Objekt „Kunde" des Gegenstandsbereichs „Banking Business". In einem generischen Framework findet sich keine Klasse „Kunde", keine Klasse „Kundenrecord" in Headerfiles, kein GUI ressource file für eine „Kundenmaske". Was das generische Framework benötigt um ein Objekt „Kunde" des Gegenstandsbereichs zu verarbeiten ist Meta Information über ein solches Objekt.

Diese Metainformation existiert nur ein einziges Mal und ist selbstbeschreibend. Das Framework kann aus dieser Metainformation Views für das GUI sowie datenbank schemata generieren. Es kann ein „Kunden" Objekt des Gegenstandsbereiches durch ein composite Object bestehend aus generischen Objekten des Frameworks repräsentieren.

Neue Anforderungen, z.B. Spezialisierungen von „Kunde" sind plötzlich durch Änderungen der Meta Informationen möglich und erzwingen keine neuen Module (Puzzle Teile)

Hauptzweck der analytischen Struktur ist Abstraktion durch Dekomposition. Eine Besonderheit dabei ist, dass dabei MetaInformation entsteht die programmatisch sichtbar werden muss, d.h. das Framework muss darauf programmatischen Zugriff haben.

Dies findet in der reflektiven Struktur (s.u.) statt. Das wiederum bedeutet, dass die meta information NICHT Dokumentation im Sinne zusätzlicher Schriftstücke sein kann. Sie muss zur Laufzeit zur Verfügung stehen, gepflegt und angepasst werden. Meist geschieht das mit Hilfe des Frameworks selbst, d.h. mit Hilfe von logischen und physischen Elementen die aber zur Reflektiven Struktur des Frameworks gehören.

A generic framework that represents objects with meta information.

Ganz ähnlich einem „aspect weaver" [AOP] setzt das Framework zur Laufzeit eine Instanz von sich so zusammen, dass das Objekt des Gegenstandsbereiches bearbeitet werden kann.

Die analytische Struktur eines generischen Frameworks erarbeitet die Meta Informationen. Die Granularität der „hot spots" ist nicht mehr nur auf Objekt Level sondern lediglich durch die Mächtigkeit der Meta Information beschränkt. Generische Frameworks gleichen eher Betriebssystemen als speziellen Applikationen.

Die reflektive Struktur ist die Reflexionsebene [KZIK] eines Frameworks. Reflektiert werden zwei Dinge:

Somit ist nicht nur die Bearbeitung von Business Objekten eine Aufgabe für ein Framework sondern auch die eigenen Software Strukturen die über die Flexibilität und Erweiterbarkeit entscheiden.

Typische Reflektive Elemente sind das Interface bzw. Implementation Repository und Meta Struktur Beschreibungen wie der Aufbau eines Records einer Datenbank.

Die Reflektive Struktur eines Frameworks bietet einen KONSTRUKTIVEN, PROGRAMMATISCHEN Zugriff auf die Ergebnisse der Analytischen Struktur.

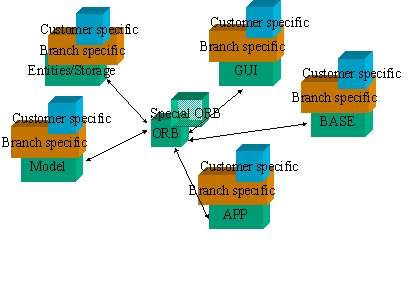

Unter logischer Struktur eines Software Paketes versteht man die Faktorisierung des Problembereichs ohne Beachtung physischer Komponenten. (z.B. „Domains/Services", Base, HIC, Schnittstellen von außen (Bibliotheksverwendung) und innen (Einfügen von applikationsspezifischen Erweiterungen) etc.

Wie wichtig es es, die logischen und physischen Aspekte GEDANKLICH zu trennen zeigt sich daran, dass im NEWSYS Projekt die logischen Domains weiterhin verwendet werden konnten (HIC,PDC,DMC). Sie waren auch keineswegs falsch gewesen sondern lediglich auf undurchsichtige Weise mit physischen Aspekten vermischt worden.

Immer unterscheiden zwischen der logischen Komponente XX als Service oder Domain und den sie realisierenden physischen Packages XX.exe, XX.dll, BranchXX.dll, CustomerXX.dll, WhatEverXX.dll, WhatEver.exe!

Die logische Stuktur enthält unter anderem:

Zentrale Abstraktionen, z.B. das verwendete Dokumentenmodell

die Ableitungsverhältnisse (Basisklassen, Defaultimplementationen, Applikationsspezifische Ableitungen)

das Objekt Modell (Root Klasse, Object Request Broker, Hilfsklassen, Konkrete Klassen)

die verwendeten Design Patterns (möglichst als programmatische Entities!)

die Verwendungsregeln z.B. bezüglich des Memory Managements und Reference Countings

Logische Aspekte der Interface/Implementation Trennung (HotSpot Design)

In NEWSYS entstand Dokumentation in Design Pattern Struktur zu:

Dokumentenmodell (Parts)

ORB, Memory Management und Object Modell(Superfactory NSys)

Implementation von Factories,

der Integration von Fremdprodukten durch Wrapper und Adaptoren

Meta Information (System Config, Documents, Database schemas)

Sub-frameworks (data management, Entity Management)

Software Wartung mit Design Patterns

Überraschenderweise liessen sich Design Patterns sogar zur Software Wartung einsetzen. So konnte in einem Fall durch die Verwendung des Bridge patterns eine Implementation eines Composite Message Patterns durch zwei getrennte Implementationen ersetzt werden OHNE dass sich Änderungen am Interface ergeben hätten. Die physischen Auswirkungen blieben auf ein Package begrenzt. Kein anderes Package musste compiliert oder neu gelinkt werden.

Dies zeigt andererseits nur, dass die Trennung logisch – physisch eine gedankliche ist. Beide Strukturen lassen sich auch aufeinander anwenden.

Viele Teile der logischen Struktur richteten sich an Standards aus, deshalb sei an dieser Stelle auch auf die Dokumentation zu CORBA und ORBIX sowie auf die einschlägige SGML Literatur verwiesen.

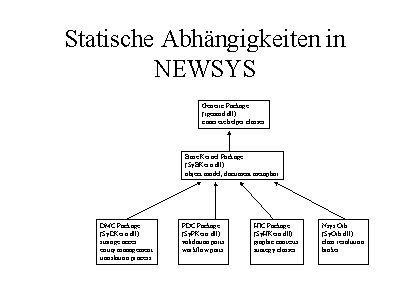

Ein Hinweis auf die Zugehörigkeit einer Klasse oder Funktion zu einer logischen Domain ergibt sich aus dem jeweiligen Kürzel am Anfang des Namens. z.B. sind alle SyBxxxxxx.xxx Teil der logischen BASE.

(zu den Namens- und anderen Konventionen von NEWSYS siehe unten: Coding Standard)

Unter der physischen Struktur eines Software Paketes versteht man

Aufteilung von Repositories, Configuration Information in physische Entities

Die Zusammenfassung von Objekt Modulen zu Komponenten (Packages) sowie die Definition deren Funktionalität. Damit verbunden ist die Organisationsweise des Source Code Trees.

Die Definition bestimmter Packages als zum Basissystem gehörig bzw. applikationsspezifische Erweiterung

Compile- und Linktime bzw. Runtime Abhängigkeiten der einzelnen Packages untereinander

Die Auslieferungsform (Dlls, libraries, exes, config files etc.)

Performance Aspekte (z.B. Degeneration von Implementationen durch Zahl oder Umfang der Objekte)

Scaling Structure: Wo sind cold spots die bei Erweiterungen physikalisch nicht skalieren?

Bei der physischen Struktur kommt deutlich eine selbstbezügliches Element des Frameworks zur Geltung. Damit die physiche Struktur ihre Leistungen erbringen kann, stützt sich sich ihrerseits wieder auf Mechanismen der logischen Struktur (Klassen, Regeln etc.) Dieses Element der Selbstbezüglichkeit taucht immer wieder auf, z.B. wenn Konfigurationsfiles als Dokumente aufgefaßt werden, damit sie mit denselben Mitteln des Frameworks für allgemeine Dokumenttypen bearbeitet werden können OBWOHL sie das Framework selbst beschreiben.

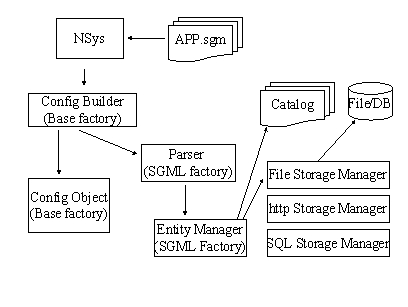

So verwendet das Konfigurationsframework innerhalb von NEWSYS genau wie eine Belegapplikation die Dokument Parts des Frameworks. Dies verringert die Zahl der Klassen und Interfaces enorm und bringt leichtere Handhabbarkeit und Polymorphie im Einsatz der Klassen:

Beispiel: